Một trong những điều đầu tiên bạn cần phải kiểm tra và tối ưu hóa khi làm việc về Technical SEO của bạn đó chính là file robots.txt. Bạn biết chưa, sự cố hoặc cấu hình sai trong file robots.txt của bạn có thể gây ra các vấn đề SEO quan trọng và tác động tiêu cực đến vị trí xếp hạng và lượng truy cập của khách hàng đến website của bạn. Trong bài viết này, bạn sẽ biết được file robots.txt là gì, tại sao bạn lại cần robots.txt, làm thế nào để SEO tối ưu hóa robots.txt, cùng theo dõi ngay nhé.

Mục Lục

File robots.txt có nghĩa là gì?

Robots.txt là một tệp văn bản mà chủ sở hữu trang web có thể tạo để cho các bot của công cụ tìm kiếm biết cách thu thập thông tin và lập chỉ mục các trang trên trang web của họ. Nó thường được lưu trữ trong thư mục gốc còn được gọi là thư mục chính của trang web của bạn. Định dạng cơ bản cho tệp robots.txt trông giống như sau:

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

Bạn có thể thêm nhiều dòng hướng dẫn để cho phép hoặc không cho phép các URL cụ thể và thêm nhiều sơ đồ trang web. Nếu bạn không cho phép một URL, thì các bot của công cụ tìm kiếm sẽ cho rằng chúng được phép thu thập dữ liệu đó và sẽ không lập chỉ mục cho url đó.

Có nhất thiết cần sơ đồ robots.txt cho website không?

Nếu bạn không có một tập tin robots.txt, thì các công cụ tìm kiếm vẫn sẽ thu thập dữ liệu và lập chỉ mục trang web của bạn. Tuy nhiên, bạn sẽ không thể thông báo cho các công cụ tìm kiếm những trang hoặc thư mục nào họ không nên thu thập dữ liệu.

Điều này sẽ không ảnh hưởng nhiều khi bạn bắt đầu làm một blog và không có nhiều nội dung. Tuy nhiên, khi trang web của bạn phát triển và bạn có rất nhiều nội dung, thì bạn có thể muốn kiểm soát tốt hơn cách trang web của bạn được thu thập và lập chỉ mục. Bot tìm kiếm có một hạn ngạch thu thập dữ liệu cho mỗi trang web. Điều này có nghĩa là họ thu thập dữ liệu một số trang nhất định trong phiên thu thập thông tin. Nếu họ không hoàn thành việc thu thập dữ liệu tất cả các trang trên trang web của bạn, thì họ sẽ quay lại và tiếp tục thu thập thông tin trong phiên tiếp theo.

Điều này có thể làm chậm tốc độ lập chỉ mục trang web của bạn. Bạn có thể khắc phục điều này bằng cách không cho phép các bot tìm kiếm cố gắng thu thập dữ liệu các trang không cần thiết. Như trang quản trị wp-admin, thư mục plugin và thư mục theme.

File robots.txt chuẩn sẽ như thế nào?

Có khá nhiều mẫu và mỗi website đều có một kiểu đặt file robots.txt khác nhau. Nhưng đa số là đặt kiểu này:

User-agent: *

Disallow:

Sitemap: http://www.example.com/post-sitemap.xml

Sitemap: http://www.example.com/page-sitemap.xml

Còn đối với một số trang web chạy bằng wordpress thì các bạn nên để thế này:

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Disallow: /readme.html

Disallow: /refer/

Sitemap: http://www.example.com/post-sitemap.xml

Sitemap: http://www.example.com/page-sitemap.xml

Điều này yêu cầu các bot tìm kiếm lập chỉ mục tất cả các hình ảnh và tệp WordPress. Nó không cho phép các bot tìm kiếm lập chỉ mục các tệp plugin WordPress, khu vực quản trị WordPress, tệp readme WordPress và các liên kết liên kết.

Làm thế nào để tạo file robots.txt trong WordPress?

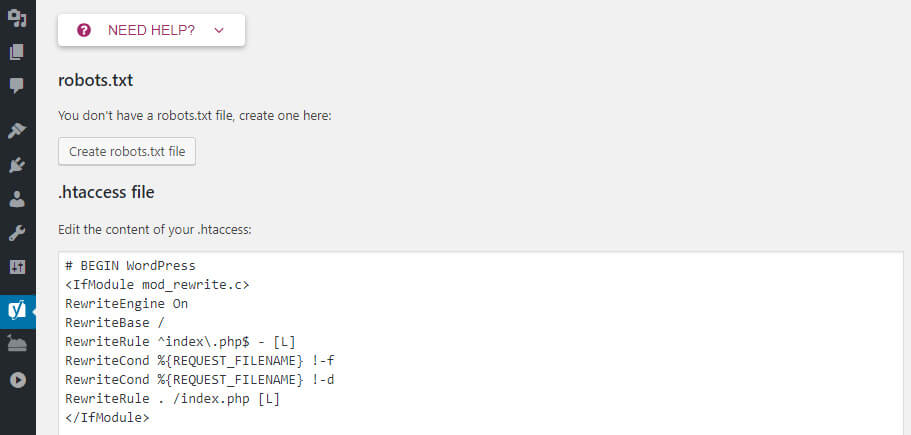

* Phương pháp 1: Sử dụng plugin Yoast Seo

Nếu bạn đang sử dụng plugin Yoast SEO , thì plugin này đi kèm với trình tạo tệp robots.txt. Chỉ cần truy cập trang SEO » Tool trong quản trị viên WordPress của bạn và nhấp vào liên kết File Editor link.

fileeditortool

Trên trang tiếp theo, trang Yoast SEO sẽ hiển thị tệp robots.txt hiện có của bạn.Nếu bạn không có tệp robots.txt, thì Yoast SEO sẽ tạo tệp robots.txt cho bạn.

Theo mặc định, trình tạo tệp robots.txt của Yoast SEO sẽ thêm các quy tắc sau vào tệp robots.txt của bạn:

User-agent: *

Disallow: /

* Phương pháp 2. Chỉnh sửa tệp Robots.txt theo cách thủ công bằng FTP. Khi vào bên trong mục lưu trữ trên hosting, bạn sẽ có thể thấy tệp robots.txt trong thư mục gốc của trang web của bạn.

Nếu bạn không thấy tệp này, thì có thể bạn không có tệp robots.txt. Trong trường hợp đó, bạn có thể tiếp tục và tạo một tệp bằng notepad cũng được.

Cách kiểm tra robots.txt đã đẩy lên thành công hay chưa?

Khi bạn đã tạo tệp robots.txt của mình, bạn nên kiểm tra tệp đó bằng công cụ kiểm tra robots.txt. Có rất nhiều công cụ kiểm tra robots.txt trên mạng; nhưng chúng tôi khuyên bạn nên sử dụng công cụ bên trong Google Search Console. OK như vậy là đã xong – chúc các bạn thành công trong việc tạo và đẩy file robots.txt lên.